Tomada de decisões em bioética e a agência moral da IA: hora de (re)pensar?

Texto traduzido do artigo originalmente publicado em inglês pelo autor no newsletter Professional Formation Update, em outubro de 2023.

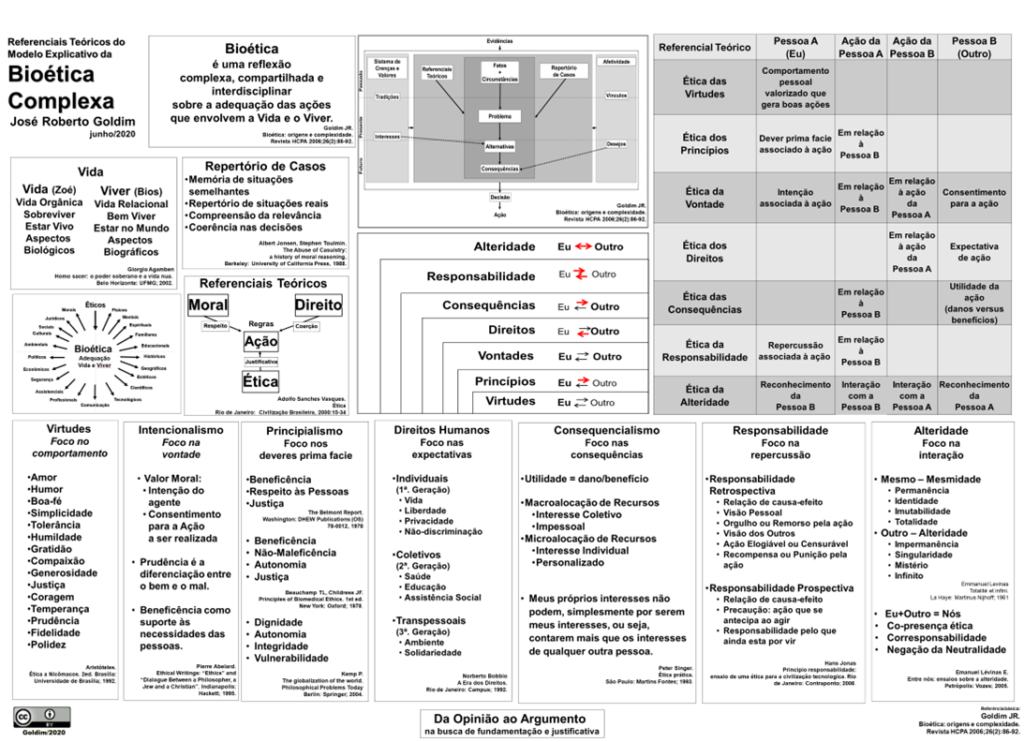

Com toda a comoção recente em torno da inteligência artificial (IA), tornou-se mais evidente que nossa sociedade vive um impasse: por um lado, há um forte otimismo em torno das capacidades da inteligência artificial e seu potencial para fornecer informação confiável, sendo até mesmo capaz de superar especialistas; por outro, múltiplas declarações por figuras influentes sinalizam o que Luciano Floridi chamou do “Inverno da IA” — um sentimento coletivo complexo que une uma decepção referente às capacidades dessa nova tecnologia com uma desconfiança abrangente em torno dela. Domenico de Masi, pensador falecido recentemente, pintou a imagem de um futuro otimista no qual a tecnologia libertaria os humanos dos trabalhos servis e repetitivos, o tipo que aliena indivíduos de seus propósitos existenciais. Entretanto, estamos observando o oposto disso: os trabalhos perdidos para robôs têm sido aqueles relacionados à expressão artística, à expertise profissional e à reflexão ética. Esse é o caso com decisões relacionadas à bioética, profundamente fundamentadas na agência moral daqueles que deliberam a respeito delas.

Há um medo nauseante sobre a IA substituir humanos nas tomadas de decisão em bioética. Esse é precisamente o porquê de devermos discutir o assunto. Por séculos, fazer o certo foi considerado uma virtude fria, baseada na reflexão racional do agente. Da mesma forma, a personalidade esteve atribuída ao mesmo tipo de capacidade. Se num exercício hipotético imaginarmos um tipo de IA capaz de reproduzir qualquer tipo de atividade de que um cérebro humano é capaz (a chamada de “inteligência artificial geral”, ou AIG), por que se preocupar com a IA tomando nossos lugares e poupando seres humanos do stress moral de tomar decisões de alto impacto?

De fato, muito do avanço do pensamento em bioética (em especial no âmbito clínico) se deu em direção à codificação ou procedimentalização: com sistemas como a “abordagem dos quatro tópicos“, a bioética se torna mais fácil de ser ensinada, reproduzida, e adotada em nível institucional, delegando muito do trabalho pesado à própria organização. Como colocado pela antropóloga Mary Douglas, instituições tomam muitas das decisões difíceis, mesmo aquelas referentes a situações de vida ou morte. Mas reconhecer que muito do que é buscado pela IA já foi explorado por nossas tecnologias sociais não resolve nosso desconforto. Talvez porque o conceito de agência moral e o papel que atribuímos a ela esteja errado.

Decisões em bioética são complexas. A racionalidade é acompanhada por medo, empatia, sorte, fé e tradição. Muitos desses fatores parecem afetar de alguma maneira a agência moral. Isso não foi ignorado pelo pensamento ético contemporâneo: Paul Ricoeur, por exemplo, argumenta que a agência moral é concorrente com nossa identidade narrativa. Ela é reflexiva, manifestando-se como nossa capacidade para julgar a nós mesmos, os outros, e ser julgado pelos demais. Isso resulta da própria identidade, conforme construímos nosso caráter através da sucessão de nossas ações enquanto buscamos por congruência moral ao sermos fiéis às nossas palavras. Essa lacuna é conectada por nossos esforços em contar nossa própria história, através da qual construímos nossa identidade narrativa ao organizar nossos eventos pessoais e experiências em um enredo cheio de sentido — abraçando nossas emoções e nos convidando à autorreflexão.

Mesmo que cogitemos que a AIG possa ser capaz de desenvolver alguma forma de identidade narrativa, parece desafiador desconsiderar como determinantes como valores sociais e elementos biologicamente condicionados têm o seu papel na tomada de decisões. Esses também são parte do nosso senso de responsabilidade moral. Corporeidade, dor e nossa identidade para com o grupo e a espécie humana são alguns dos elementos que parecem limitar a confiabilidade de se delegar escolhas morais a esses tipos de inteligência artificial.

Contudo, isso não significa que a IA deva ser excluída das tomadas de decisão em bioética. Da mesma forma com que adscrevemos uma capacidade parcial a nossas instituições (na forma de sua personificação enquanto empresas, associações e outras entidades), também deveríamos conceber a inteligência artificial enquanto uma extensão da nossa cognição que expande as nossas capacidades. Ela pode nos ajudar a alcançar a consistência nas deliberações éticas, ao refletir valores institucionais; pode nos suprir com informações organizadas; e, por fim, convidar operadores humanos a refletir a respeito de seus vieses e falhas intrínsecas, algo que é parte de como construímos nossa identidade e bússola moral. Isso é algo a ser considerado por nossas estruturas sociais, como sistemas jurídicos, que tanto vêm tido dificuldades com a regulação do papel da inteligência artificial. Nossa experiência sempre foi mediada por alguma forma de tecnologia. Então por que deveria ser diferente com a IA?